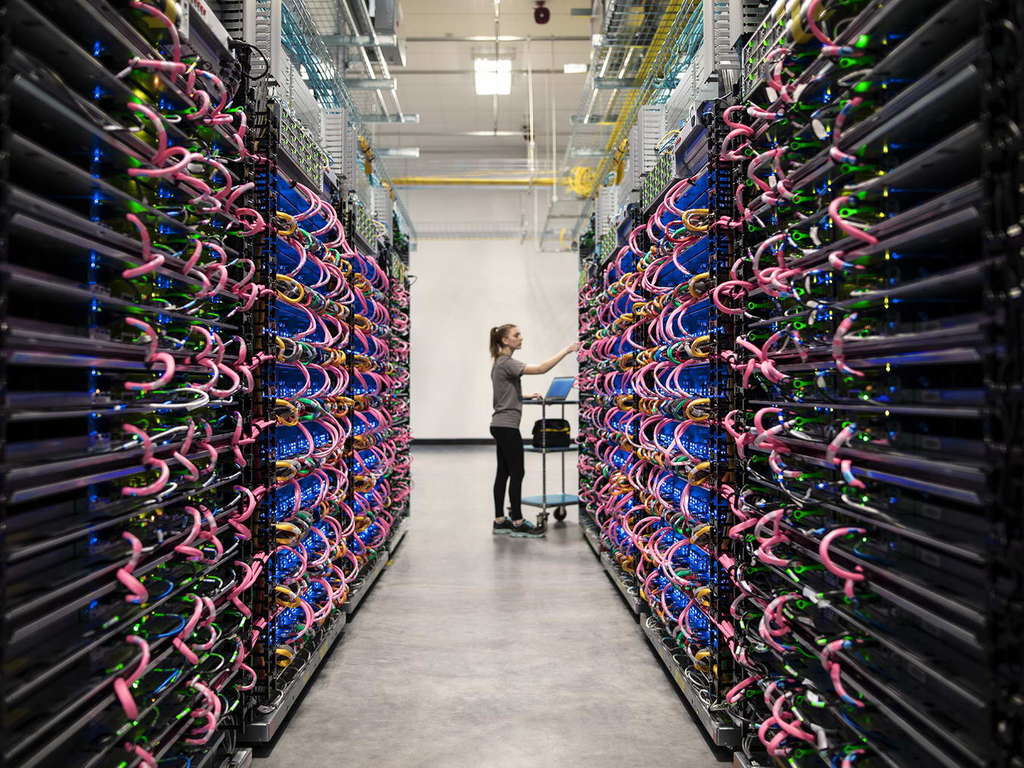

【e-zone 專訊】Google 在人工智能(AI)的野心昭然若揭,尤其在「平民化」(應是商用化)。繼早前向推出 Cloud AutoML 工具供一般公司自行建構機器學習(Machine Learning)模型後,今日又宣布開放其自行研發的 TPU(Tensor Processing Unit)晶片供外界租用,助研發人員加快訓練深度學習(Deep Learning)模型。

Google Cloud Platform 香港時間今日在其網誌稱,Cloud TPU 仍處於測試階段,開放的數量有限,故外界想用需先申請,每小時租金 6.5 美元。Google 一直有用 TPU 在其搜尋、改善 Google 翻譯以及其他 AI 技術軟件的機器學習模型。今次是首次開給外界試用。

專攻 AI 更勝 CPU

Google 在 2016 年推出 TPU,並於去年 5 月 Google I/O 開發大會推出第二代 TPU2 Cloud TPU 系統。TPU2 性能最高為 180teraflops(每秒 180 兆次浮點運算),若將 TPU 組合成基建,可提供達 11,500 兆次浮點運算(11.5petaflops )。

Google 一連串舉動勢將 AI 開發、特別是基礎硬件製造商。受影響第一批公司的是對英特爾(Intel)、輝達(Nvidia)等中央處理器(CPU)及圖像處理器(GPU)等傳統晶片製造商。Nvidia 近年轉型以 GPU 作為 AI 研發人工智能工具,亦是首批提供 GPU(如:Tesla P100)租用服務的公司,連 Google 也是 TPU 跟 GPU 並用,但當 TPU 技術成熟相信 Google 會放棄 GPU 甚至 CPU 作 AI 模型研發,還要搶走 Nvidia 的生意。

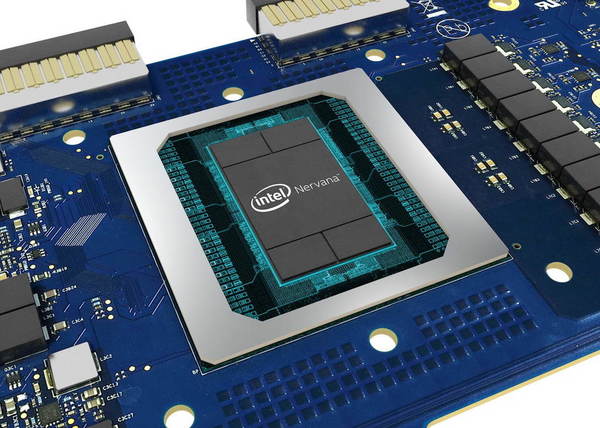

英特爾呢?主攻通用運算功能的 CPU 實在不夠為 AI 模型等特定用途設計的 TPU 鬥,因後者屬 ASIC,即專為特定用途而製的晶片。不過,Intel 也嚴陣以待,2016 年收購 Nervana Systems,去年底推出曾稱為「Lake Crest」的 NNP(神經網絡處理器),並推出 neon 2.6.0 架構,優化 Xeon 處理器成為適合執行 AI 研發的通用平台,總之不讓 Google 踩過界。

另一家「深度使用」雲端基建技術的服務商亦打算跟 Google 走同一路線 - 說的是 Amazon.com。該公司眼見 Google 跟硬件商鬥得燦爛也加入戰團:自行研發 AI 專用處理器,助 Alexa 數碼助理改善效能,以及加強 AWS 服務。事實上,Amazon 早在 2015 年便以 3.5 億美元收購以色列晶片設計公司 Annapurna Labs,自行生產專用晶片之心明顯不過。

Source:ezone.hk